Pour le cas du japonais, rien n'a été de tout repos malheureusement. Beaucoup d'essais, énormément de raté, mais quelques solutions pour pallier aux différents problèmes !

Les mêmes commandes déjà énoncé dans ce blog lui ont été appliqué:

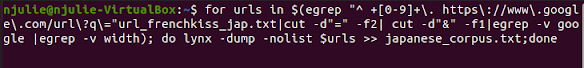

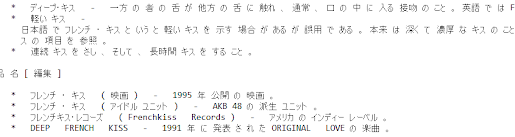

Après tous les traitement, on se rend compte qu'il y a toujours beaucoup de "saletés", de bruits sur les urls. On commence par les trier à la main mais, il y a trop de contenu (plus de 300) alors, pour éviter de perdre du temps avec les problèmes d'apparitions des "binary files" etc, on relance une nouvelle récolte d'urls en étant encore plus précis. Le fichier urls de japonais se créer. On lance la commande du terminal pour avoir un tableau.

Quel bazar ! janome doit être installé sur le terminal unix par la commande:

Enfin un corpus bien tokenisé ! On nettoie le corpus à la main, pour qu'il n'y ait pas de "bruit" et pour pouvoir mettre le corpus sous iTrameur. Bien sûr, on oublie pas de rédiger l'analyse et une belle conclusion !

Donc tout est prêt pour le site finale !

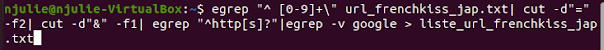

Pour ce qui est de la récolte des urls japonais pour le mot French Kiss (フレンチキス) , a été appliqué la fameuse commande déjà utilisé pour la langue française, anglaise, espagnol et turc.

Les mêmes commandes déjà énoncé dans ce blog lui ont été appliqué:

Problème :

message d'erreur:

...et aucun tableau à l'horizon. On essaye d'autre script, d'en refaire nous même, toutes les possibilités qui pourraient nous aider... rien ne marche. Monsieur Fleury (merci à vous!) est venu à la rescousse.

Il nous suggère de travailler avec le tokenizer janome pour le japonais et nous laisse les pistes et nous dirige vers les blogs des années passées, afin d'exécuter le tokenizer sur notre corpus.

pip install janome

En fait, janome est un tokenizer qui doit être écrit sur un script python, et c'est ce script python que l'on doit faire appeler sur notre script bash.

J'ai essayé de suivre les instructions des anciens blogs mais rien à faire, ça ne veut pas marcher pour des raisons que j'ignore encore aujourd'hui. Mais le temps presse et nous en avons déjà beaucoup perdu... Que faire pour avoir notre tableau et avoir notre corpus tokenisé ?

Première solution : Monsieur Fleury nous a suggéré de revoir notre script où il fait remarqué que certains liens sont encodés en autre choses que utf-8. Donc il fallait harmonier cela dans une boucle, pour que le traitement des urls encodé en autre chose que utf-8 puisse bien se passer.

Après avoir résolu ce premier soucis, un autre montre le bout de son museau...

Résultat : bof, un tableau se lance mais pas très bien fait... on se dit que ca doit surement venir des urls. On refait une récolte d'urls "propres" en le faisant manuellement sur notepad++ en faisant un retour chariot par url récolté. ATTENTION au retour à la ligne CRLF (pour Windows) ou LF (pour unix). On relance la commande, c'est beaucoup mieux, mais pas assez ! Il y a certains liens qui montre 0... On essaie de relancer avec un autre script, toujours pareil. Pas très net tout ça... Alors on redemande à M. Fleury (désolé encore!)

Deuxième point : il nous pointe la chose suivante : nous avons 3 boucles de condition pour pouvoir traiter correctement les liens selon leur encodage, mais nous ne faisons appelle à notre tokenizer python que dans la première boucle. Or, ce traitement doit se faire tout au long des traitements des liens urls. Alors, l'idée est de placé janome dans la boucle mais pour chacune d'entre elle. Ouff! de l'espoir en vue !

Résultat : pas concluant... rien à faire. Cela ne veut pas se lancer. On essaie de faire un autre script à part seulement pour les liens urls japonais, mais toujours au même point ! Alors, on réfléchit, l'heure tourne encore et puis on décide de faire la chose suivante :

On place le script python sur le dossier DUMP, on va sur le terminal, et on tape ceci :

python tokenizer-jp.py utf8_1-1.txt OUTPUT.txt

N.B.: dans le dossier DUMP, il y a le fichier utf8_1-1.txt

sur le terminal ubuntu, on se déplace sur le répertoire DUMP avant de lancer la commande, donc : cd pour aller vers DUMP

On s'exécute, vite, vite, et...

"C'EST BON !"

Le texte est bien tokenisé ! Il faut le faire sur tous les fichiers maintenant !

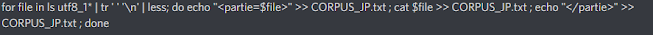

Ensuite, on concatène avec la commande qui suit :

Et c'est ainsi que nous avons trouvé une autre façon de tokeniser la langue japonaise sans le mettre sur le script .sh !

Quel stresse franchement !

Le japonais était la dernière langue qui nous restait à traiter.

Un petit mot de fin pour ce projet-ci : La partie la plus facile fut celle des nuages de mots sur wordart.com (😂). Plus sérieusement, même si ça a été fait avec les données du corpus contextes les résultats sont similaires à ceux d’iTrameur.

Merci pour ce semestre !

En espérant que ce blog aidera les M1 des prochaines années !

Commentaires

Enregistrer un commentaire